Millä meitä mitataan? | How are we measured?

(Please, scroll down to read in English.)

Yliopistomaailmassa törmää erilaisiin tutkimus- ja julkaisutoimintaa arvioiviin mittareihin, kuten impact factoriin, h-indeksiin, jufo-tasoihin sekä julkaisu- ja viittausmääriin. Lue lisää tutkimuksen arvioinnista julkaisujen avulla. Mittareiden avulla saatavaa tietoa hyödynnetään esimerkiksi apurahahakemusten teossa, tehtävää tai tointa hakiessa, rekrytointia tehdessä ja tutkimustulosten julkaisukanavaa miettiessä. Mittareita tutkaillaan yhteistyökumppaneita etsiessä ja puhtaasti omasta mielenkiinnosta.

Mittareiden hakemiseen ja osittain myös laskemiseen on kehitetty erilaisia, suhteellisen yksinkertaisiakin, työkaluja ja palveluja, joten erilaisten tunnuslukujen saaminen ei sinällään välttämättä vaadi mitään erityistaitoja. Tutkimuksen ja julkaisutoiminnan arviointi on haastavaa, joten selkeän numeerisen luvun antavien mittareiden käyttäminen on houkuttelevaa. Tunnistammeko mittareiden käyttöön liittyvät rajoitukset ja osaammeko tulkita ja käyttää niitä vastuullisesti oikein?

Useimmat mittarit perustuvat siteerauksiin

Mittareista on hyötyä erityisesti sellaisilla tieteenaloilla, joilla tutkimustulokset julkaistaan artikkeleina kansainvälisissä vertaisarvioiduissa tieteellisissä lehdissä englannin kielellä. Tällaisia aloja ovat eksaktit tieteet (luonnontieteet) ja niihin perustuvat alat, kuten esimerkiksi biokemia, farmasia ja lääketiede. Toisin sanoen kyse on tieteenaloista, joiden julkaisut löytyvät metriikkaan erikoistuneista Scopus– ja Web of Science -tietokannoista.

Useimmat mittarit perustuvat siteerauksiin. Eksakteissa tieteissä viittauksiin perustuvien mittarien voidaan sanoa kuvaavan tutkimuksen vaikuttavuutta. Esimerkiksi h-indeksi suhteuttaa tutkijan julkaisumäärän ja siteerausmäärän toisiinsa. Mitä korkeampi h-indeksin arvo on, sitä enemmän tutkijalla on siteerattuja kärkijulkaisuja. Siteeraaminen on yksi osoitus siitä, että tutkimus tulee huomatuksi ja että sillä on merkitystä.

Mittarit ovat saman tieteenalan sisällä puolueettomia ja niiden laskentaperusteet läpinäkyviä. Numerot ovat faktaa eivätkä mielipiteitä. Esimerkiksi erilaisten akateemisten tehtävien täytöissä tällä on merkitystä. Valitsijat voivat saada mittarien avulla jokseenkin vertailukelpoisen kuvan hakijoiden tieteellisistä ansioista kansainvälisellä tasolla. Mittareiden aikasarjaa tutkimalla voidaan selvittää myös tutkijan urakehitystä: onko ura nousevassa vaiheessa, jo vakiintunut, vaiko mahdollisesti laskusuunnassa.

mittareiden soveltuvuus vaihtelee tieteenaloittain

Humanistisia ja yhteiskuntatieteitä pidetään yleensä perinteisen metriikan välineillä tehtävään mittaukseen huonosti soveltuvina: näiden alojen lehdistä vain osa on Web of Sciencessa ja Scopuksessa, joiden ulkopuolelle jäävät myös monilla tieteenaloilla julkaisukanavina tärkeät monografiat. Tilanne ei toisaalta ole näin yksiselitteinen: artikkelijulkaisemisen yleistyessä perinteisillä kirja-aloilla mittaaminen käy eri tavalla mahdolliseksi, ja esimerkiksi Google Scholar ottaa huomioon myös kirjat ja niiden saamat viitteet. Lisäksi jotkin tieteenalat myös humanististen ja yhteiskuntatieteiden sisällä istuvat paremmin perinteisen metriikan välinein mitattaviksi. Vaikkapa psykologian ja neurolingvistiikan julkaisut ovat aivan eri tavalla mitattavissa kuin historia ja oikeustieteet. Tällöin korostuu jo aiemmin esiin tullut ohjenuora: eri tieteenaloja ei voi verrata keskenään.

altmetriikka

Tutkimusjulkaisujen näkyvyyden arvioinnissa käytetään myös vaihtoehtoiseksi metriikaksi ja artikkelitason metriikaksi nimitettyä altmetriikkaa, jonka ideana on selvittää, mitä tieteessä tapahtuu juuri nyt perinteisen metriikan analysoidessa jo tapahtunutta. Altmetriikan avulla voidaan seurata, miten paljon tiettyä julkaisua verkossa ladataan, jaetaan ja kommentoidaan.

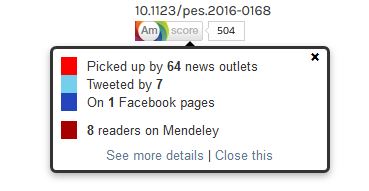

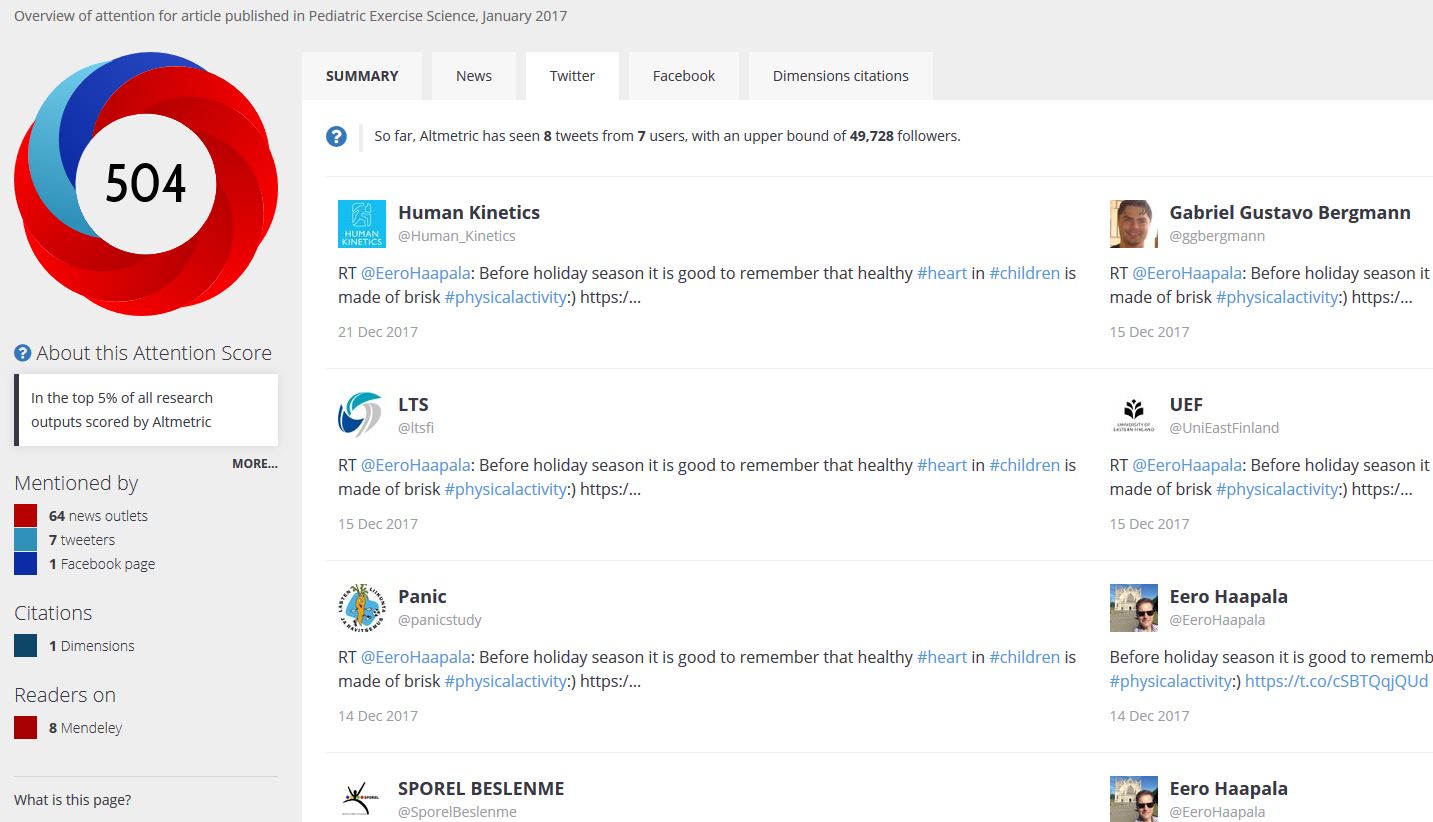

Altmetriikkapalveluita on sekä maksuttomia, esim. Altmetric (osittain) ja Kudos, että maksullisia, esim. SciVal (käytössä UEFissa, myös perinteistä metriikkaa) ja PlumX. Monissa palveluissa, muun muassa UEF eRepossa, on käytössä Altmetric-palvelun huomiopisteiden (attention score) kuvake, niin sanottu donitsi. Klikkaamalla sitä on helppo nähdä, missä julkaisua on jaettu ja keskustellaanko siitä vaikkapa Twitterissä.

Altmetriikkaan kytkeytyy läheisesti tutkijoiden näkyvyys sosiaalisessa mediassa, esim. Twitter, ja verkkoyhteisöissä, esim. Academia.edu, LinkedIn, Mendeley ja ResearchGate. Lue lisää altmetriikasta ja tutkimuksen näkyvyydestä

miten tutkimuksen avoimuutta mitataan?

Tutkimustiedon avoin saatavuus ja tutkimuksen läpinäkyvyys ovat tieteellisen prosessin kulmakiviä. Jo tällä hetkellä useat rahoittajat, kuten Euroopan komission Horisontti 2020 -ohjelma ja Suomen Akatemia, edellyttävät avointa julkaisemista ja kannustavat tutkimusdatan avaamiseen, kun avaamiselle ei ole juridisia, eettisiä tai sopimusoikeudellisia esteitä. Tieteen avoimuuden tukeminen on keskeinen tavoite niin kotimaisissa kuin kansainvälisissäkin tiedelinjauksissa, mutta työ avoimuuden mittareiden kehittämiseksi on vielä kesken. Tieteen vaikuttavuutta mittaavat metriikat perustuvat edelleen pitkälti vertaisarvioituihin kansainvälisiin julkaisuihin eivätkä tunnista avoimia menetelmiä. Avoimuuden kulttuurin muutosta tulee edistää kannusteilla ja tutkijoita palkita avoimuudesta. Tavoitteena on, että avoimuuden indikaattoreita hyödynnettäisiin aidosti mm. virantäytöissä ja tutkimusrahoituksen jakamisessa.

mittareiden vastuullinen käyttö

Miten tutkimus- ja julkaisutoimintaa kuvaavia mittareita sitten tulisi käyttää? Ensinnäkin, arvioinnin lähtökohtien tulee olla mahdollisimman tarkat. Tietokannasta haettuja viitetietoja verrataan tutkijan julkaisuluetteloon. Tietokannat eivät välttämättä sisällä kaikkia tietyn tutkijan, tutkimusryhmän tai tieteenalan julkaisuja. Yliopistossamme filosofisen tiedekunnan raportointivuoden 2017 vertaisarvioiduista julkaisuista vain vajaa 45 % löytyi Scopuksesta tai Web of Sciencestä. Yhteiskuntatieteiden ja kauppatieteiden tiedekunnassa vastaava kattavuus oli 65 %. Terveystieteiden tiedekunnassa päästiin 90 %:iin ja luonnontieteiden ja metsätieteiden tiedekunnassa 94 %:iin.

Koska mittareiden antama tieto on lähinnä määrällistä, tulee niitä käyttää asiantuntija-arvioinnin rinnalla. Vastuullista käyttöä on myös se, että tarkastellaan useita mittareita samanaikaisesti. Tärkeää on muistaa, että mittareiden antamat numerotiedot ovat vertailukelpoisia vain saman tieteenalan sisällä, jos sielläkään. Lisäksi tulosten tulkintaan pitää liittää tutkijan uravaihe. Arvioinnin kohteilla tulisi olla mahdollisuus testata ja todentaa tulokset, jolloin toimintaa voidaan pitää läpinäkyvänä molemmille osapuolille.

Vastuulliseen käyttöön kuuluu myös tieteen sisäinen vuoropuhelu siitä, mihin mittareita käytetään, mittaavatko ne oikeita asioita ja onko indikaattoreissa päivittämistarpeita.

Tutkimus- ja julkaisutoiminnan mittaaminen on ajankohtainen aihe, sillä myös valtakunnallisesti on aloitettu keskustelu siitä, olisiko Suomessa tarvetta yhteisille metriikan käytön pelisäännöille. Kansallisia linjauksia mittareiden käytöstä on odotettavissa lähitulevaisuudessa. Tieteellisten seurain valtuuskunta on perustanut työryhmän valmistamaan tutkijan vastuullista arviointia koskevan suosituksen. Lisäksi samaa aihepiiriä on käsitelty Tutkimushallinnon verkostossa julkaisumetriikan työryhmässä, jonka aloitusseminaarissa käytiin läpi DORA-julistusta, Leidenin tutkimusmetriikkamanifestia ja Julkaisufoorumin vastuullista hyödyntämistä. Juuri nyt keskeistä on lisätä eri toimijoiden, kuten tutkijoiden, opettajien, rahoittajien ja tutkimushallinnon, tietoisuutta mittareiden rajoituksista ja eduista. Ihmiset tekevät vastuullisen metriikan.

Lue lisää:

Metric Tide

Metrics Toolkit

in English

Universities use different indicators, like impact factor, h-index or number of publications, to measure research output. Read more about evaluating research via publications. The information produced using these indicators is used, for example, in research grant applications, in applying for an office and in recruiting. They are also explored when looking for research partners and purely out of interest. There are different tools and services that are mostly easy to use. It is tempting to use clear numerical indicators as the assessment of research and publications is demanding. Do we recognise the limitations of these indicators? Do we know how to use them responsibly?

most indicators are based on citations

Bibliometrics is useful especially in exact sciences (natural sciences) and related disciplines, such as biochemistry, pharmacy and medicine. Publishing in these disciplines is standardised to peer-reviewed journal articles in English language. All or most of the articles may be found in Scopus and Web of Science databases. Thus, the quantitative analysis of publishing is possible. Bibliometrics is based on citations. Citation practices in science are well established. Considering all this, bibliometrics can be said to offer justified means to analyse research impact in science. Bibliometrics is objective and transparent within a discipline. Numbers represent facts. There is a need for this kind of information, e.g. in fulfilling academic positions. The applicants’ academic merits can be comparatively evaluated on an international level by using metrics. Time series of metrics are useful in finding out whether a career ladder is ascending, established or descending.

disciplines cannot be compared using bibliometrics

Usually, humanities and social sciences are not considered suitable for traditional bibliometrics. Only part of the journals in these fields are indexed for Scopus or Web of Science and monographies are not indexed at all. However, the situation is not that unequivocal as publishing articles is becoming more common also in these disciplines and as Google Scholar, for instance, counts also book refererences. In addition, some areas, such as psychology and neurolinguistics, within these fields are more fit to be measured using bibliometrics. It is just important to remember not to use metrics to compare different disciplines.

altmetrics

Altmetrics is alternative or article level metrics. The idea is to find out what happens in science right now, while traditional bibliometrics looks at what has happened. There are free tools, like Altmetric (partly free) and Kudos, and chargeable tools, like SciVal (in use at UEF, also traditional metrics) and PlumX. In many services, like in UEF eRepo, you can see the so-called attention score donut of Altmetric. By clicking it, you can find out where a publication has been shared and if it is discussed, for example, in Twitter. Researchers’ visibility in Twitter and in other social media and networking tools and services, like Adademia.edu, LinkedIn, Mendeley and ResearchGate, is closely connected to altmetrics.

how to measure openness?

The open access and the transparency of research are the keystones of the scientific process. Already several funders, such as the Horizon 2020 – EU Research and Innovation programme and the Academy of Finland, require open publishing and encourage the sharing of research data when there are no legal, ethical or contractual barriers. Supporting open science is the main goal both nationally and internationally, but the work to develop the indicators of openness is still ongoing. Impact indicators are still largely based on peer-reviewed international publications and do not recognise open methods. The change in the culture of openness should be promoted by incentives and researchers should be rewarded for openness. The goal is to genuinely utilise the indicators of openness, e.g. when employing staff and sharing research funding.

responsible metrics

How should the indicators be used? Firstly, the bases have to be exact. References from databases are compared with researcher’s publication list. Databases do not necessarily cover all publications by a researcher, a research group or a discipline. At UEF, 45% of the peer-reviewed publications of the Philosophical Faculty could be retrieved from Scopus or Web of Science, while the figure was 65% for the Faculty of Social Sciences and Business Studies, 90% for the Faculty of Health Sciences, and 94% for the Faculty of Science and Forestry.

Indicators provide mostly quantitative information and that must be used together with expert evaluation. It is also responsible to use several indicators, not only one. And to always take into account that the figures are comparable only within a discipline, at most. In the interpretation of the results, the career phase of the researcher must always be taken into account. Evaluation should also be transparent. Scientists themselves are also responsible to discuss the use of these indicators.

National discussion about the need for common rules of using indicators and metrics has started. The Federation of Finnish Learned Societies (TSV) has established a working group to create guidelines of responsible researcher evaluation. The same topic has been processed in the publishing metrics working group of the Network for Research Services and Administration (TUHA). The DORA Declaration, the Leiden Manifesto and the responsible use of the Publication Forum have been studied with care. Right now, it is important to increase the knowledge about the limitations and benefits of indicators among all parties. People make responsible metrics.

Further reading:

Metric Tide

Metrics Toolkit

Kaisa Hartikainen, Jussi Hyvärinen, Heikki Laitinen, Virpi Lindi, Mari Niemi, Tuulevi Ovaska, Maarit Putous & Tomi Rosti, tietoasiantuntijoita | information specialists

Opetus- ja tietopalvelut | Training and information services

Verkko- ja julkaisupalvelut | Library IT and publishing services

Jarmo Saarti, kirjastonjohtaja | library director

Käännöksen oikoluku | English language checking: Suvi Tolvanen